推薦系統(tǒng)下載分類: 最新Windows10系統(tǒng)下載 最新Windows7系統(tǒng)下載 xp系統(tǒng)下載 電腦公司W(wǎng)indows7 64位裝機(jī)萬(wàn)能版下載

【W(wǎng)eb Scraper下載】Web Scraper網(wǎng)頁(yè)爬蟲插件 v0.5.4 最新版

- 軟件類型:編程軟件

- 軟件語(yǔ)言:簡(jiǎn)體中文

- 授權(quán)方式:免費(fèi)軟件

- 更新時(shí)間:2024-11-18

- 閱讀次數(shù):次

- 推薦星級(jí):

- 運(yùn)行環(huán)境:WinXP,Win7,Win10,Win11

軟件介紹

Web Scraper是一款非常好用的網(wǎng)頁(yè)爬蟲插件,它可以幫助用戶輕松抓取網(wǎng)站上的所有數(shù)據(jù)內(nèi)容,而且用戶完全不需要編寫任何代碼。Web Scraper適用于各種類型的網(wǎng)站,還支持將抓取的內(nèi)容導(dǎo)出為CSV格式的文件,有需要的用戶快來下載吧。

Web Scraper特色功能

一個(gè)簡(jiǎn)易的網(wǎng)頁(yè)爬蟲插件,可以幫助不懂代碼的用戶實(shí)現(xiàn)數(shù)據(jù)爬取功能。

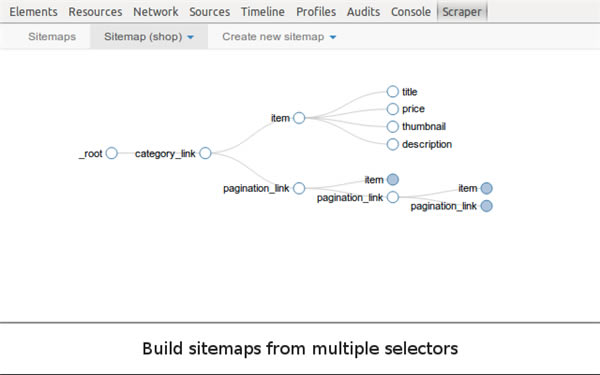

使用此擴(kuò)展,您可以創(chuàng)建一個(gè)sitemap(站點(diǎn)地圖),包含該如何遍歷網(wǎng)站以及應(yīng)提取哪些內(nèi)容等。

使用這些sitemap,Web Scraper將相應(yīng)地導(dǎo)航站點(diǎn)并提取所有數(shù)據(jù)。

稍后,可以將已篩選的數(shù)據(jù)導(dǎo)出為CSV。

Web Scraper使用教程

1、標(biāo)簽頁(yè)輸入【chrome://extensions/】進(jìn)入chrome擴(kuò)展程序,解壓你在本頁(yè)下載的Web Scraper插件,并拖入擴(kuò)展程序頁(yè)即可。

2、插件安裝完成后,在瀏覽器中會(huì)出現(xiàn)其按鈕標(biāo)記。用戶可以先在設(shè)置頁(yè)面中對(duì)該插件的儲(chǔ)存設(shè)置和儲(chǔ)存類型功能進(jìn)行設(shè)置。

3、用戶可以使用Web Scraper插件來抓取頁(yè)面,其操作方法如下:

1)、打開你要抓取的網(wǎng)頁(yè)。

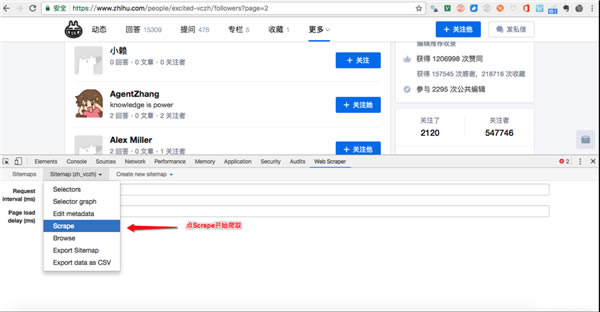

首先要使用該插件來提取網(wǎng)頁(yè)數(shù)據(jù)需要在開發(fā)者工具模式中使用,使用快捷鍵Ctrl+Shift+I/F12或者點(diǎn)擊右鍵,選擇“檢查(Inspect)”,在開發(fā)者工具下面就能看到WebScraper的Tab。如下圖所示:

2)、新建一個(gè)Sitemap。點(diǎn)擊Create New Sitemap,里面有兩個(gè)選項(xiàng),import sitemap是指導(dǎo)入一個(gè)現(xiàn)成的sitemap,咱小白一般沒有現(xiàn)成的,所以一般不選這個(gè),選create sitemap 就好。

然后進(jìn)行這兩個(gè)操作:

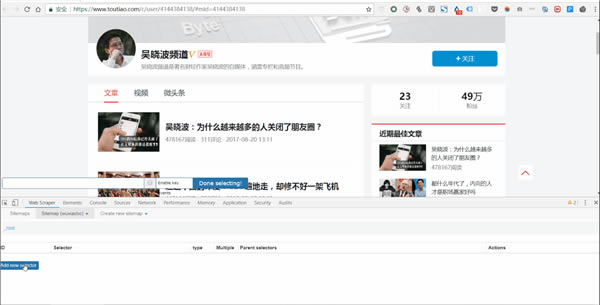

(1)Sitemap Name:代表你這個(gè)Sitemap是適用于哪一個(gè)網(wǎng)頁(yè)的,所以你可以根據(jù)網(wǎng)頁(yè)來自命名,不過需要使用英文字母,比如我抓的是今日頭條的數(shù)據(jù),那我就用toutiao來命名;

(2)Sitemap URL:把網(wǎng)頁(yè)鏈接復(fù)制到Star URL這一欄,比如圖片里我把「吳曉波頻道」的主頁(yè)鏈接復(fù)制到了這一欄,而后點(diǎn)擊下方的create sitemap來新建一個(gè)Sitemap。

3)、設(shè)置這個(gè)Sitemap

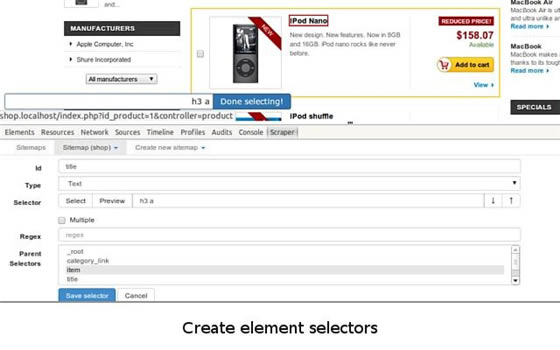

整個(gè)Web Scraper的抓取邏輯是這樣:設(shè)置一級(jí) Selector,選定抓取范圍;在一級(jí) Selector 下設(shè)置二級(jí) Selector,選定抓取字段,然后抓取。

對(duì)于文章而言,一級(jí) Selector 就是你要把這一塊文章的要素圈出來,這個(gè)要素可能包含了 標(biāo)題、作者、發(fā)布時(shí)間、評(píng)論數(shù)等等,然后我們?cè)僭诙?jí) Selector 中挑出我們要的要素,比如標(biāo)題、作者、閱讀數(shù)。

下面我們來拆解這個(gè)設(shè)置一級(jí)、二級(jí) Selector 的工作流:

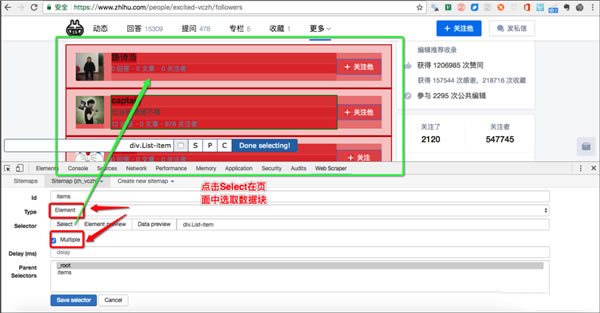

(1)點(diǎn)擊 Add new selector 創(chuàng)建一級(jí) Selector。

而后按照以下步驟操作:

輸入id:id代表你抓取的整個(gè)范圍,比如這里是文章,我們可以命名為wuxiaoboarticles;

選擇Type:type 代表你抓取的這部分的類型,比如元素/文本/鏈接,因?yàn)檫@個(gè)是整個(gè)文章要素范圍選取,我們需要用Element 來先整體選取(如果這個(gè)網(wǎng)頁(yè)需要滑動(dòng)加載更多,那就選 Element Scroll Down);

勾選Multiple:勾選 Multiple 前面的小框,因?yàn)槟阋x的是多個(gè)元素而不是單個(gè)元素,當(dāng)我們勾選的時(shí)候,爬蟲插件會(huì)幫助我們識(shí)別多篇同類的文章;

保留設(shè)置:其余未提及部分保留默認(rèn)設(shè)置。

(2)點(diǎn)擊select選擇范圍,按照以下步驟操作:

選擇范圍:用鼠標(biāo)選擇你要爬取數(shù)據(jù)的范圍,綠色是待選區(qū)域,用鼠標(biāo)點(diǎn)擊后變?yōu)榧t色,才是選中了這塊區(qū)域;

多選:不要只選一個(gè),下面的也要選,否則爬出來的數(shù)據(jù)也只有一行;

完成選擇:記得點(diǎn)Done Selecting;

保存:點(diǎn)擊Save Selector。

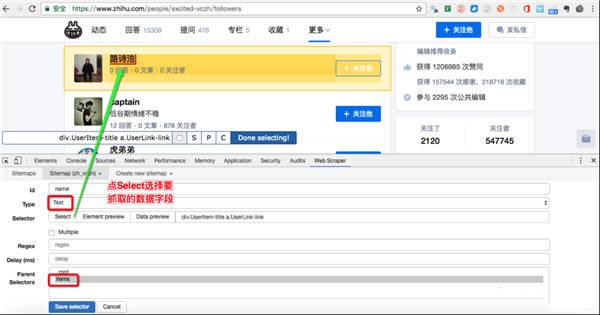

(3)設(shè)置好了這個(gè)一級(jí)的Selector之后,點(diǎn)進(jìn)去設(shè)置二級(jí)的Selector,按照以下步驟操作:

新建Selector:點(diǎn)擊 Add new selector ;

輸入id:id代表你抓取的是哪個(gè)字段,所以可以取該字段的英文,比如我要選「作者」,我就寫「writer」;

選擇Type:選Text,因?yàn)槟阋ト〉氖俏谋荆?/p>

勿勾選Multiple:不要勾選 Multiple 前面的小框,因?yàn)槲覀冊(cè)谶@里要抓取的是單個(gè)元素;

保留設(shè)置:其余未提及部分保留默認(rèn)設(shè)置。

(4)點(diǎn)擊 select,再點(diǎn)擊你要爬取的字段,按照以下步驟操作:

選擇字段:這里爬取的字段是單個(gè)的,用鼠標(biāo)點(diǎn)擊該字段即可選定,比如要爬標(biāo)題,那就用鼠標(biāo)點(diǎn)擊某篇文章的標(biāo)題,當(dāng)字段所在區(qū)域變紅即為選中;

完成選擇:記得點(diǎn) Done Selecting;

保存:點(diǎn)擊 Save Selector。

(5)重復(fù)以上操作,直到選完你想爬的字段。

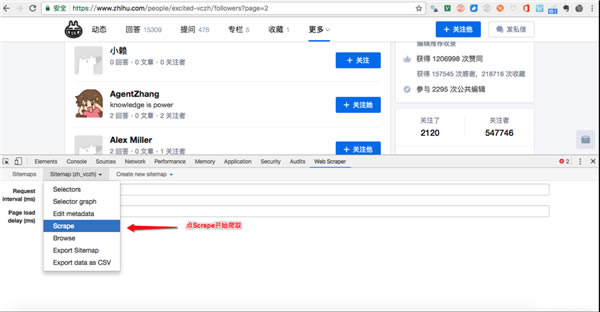

4、爬取數(shù)據(jù)

(1)之后你想要爬取數(shù)據(jù)只需要設(shè)置完所有的Selector就可以開始:

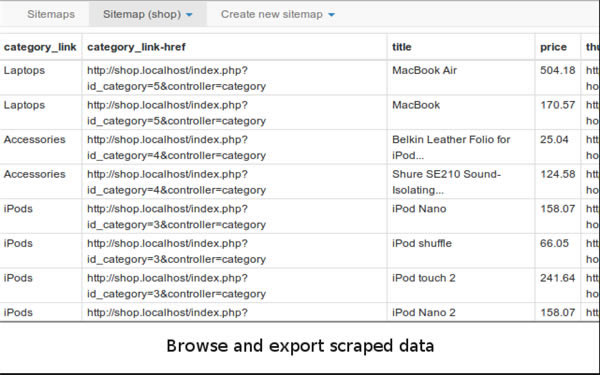

點(diǎn)擊Scrape,然后點(diǎn)Start Scraping,彈出一個(gè)小窗后爬蟲就會(huì)開始工作。你會(huì)得到一個(gè)列表,上面有你想要的所有數(shù)據(jù)。

(2)如果你希望把這些數(shù)據(jù)做一個(gè)排序,比如按照閱讀量、贊數(shù)、作者等指標(biāo)排序,讓數(shù)據(jù)更一目了然,那么你可以點(diǎn)擊 Export Data as CSV,把它導(dǎo)入 Excel 表里。

(3)導(dǎo)入 Excel 表格之后,你就可以對(duì)數(shù)據(jù)進(jìn)行篩選了。

我們這里只是簡(jiǎn)單介紹總結(jié)了Web Scraper的插件的功能,安裝以及一個(gè)簡(jiǎn)單的單頁(yè)面例子。其實(shí)Web Scraper的功能遠(yuǎn)遠(yuǎn)不止于此,其實(shí)還能抓取分頁(yè),還能多頁(yè)多元素的抓取,還能抓取二級(jí)頁(yè)面。

1贛教云教學(xué)通2.0-贛教云教學(xué)通2.0下載 v5......

2step7 microwin-西門子PLC S7......

3百度網(wǎng)盤清爽精簡(jiǎn)純凈版-網(wǎng)盤工具-百度網(wǎng)盤清爽精......

4360安全瀏覽器-瀏覽器-360安全瀏覽器下載 ......

5谷歌瀏覽器 XP版-谷歌瀏覽器 XP版-谷歌瀏覽......

6Kittenblock重慶教育專用版-機(jī)器人編程......

7seo外鏈助手(超級(jí)外鏈) -SEO外鏈優(yōu)化工具......

8Notepad3-記事本軟件-Notepad3下......

9小米運(yùn)動(dòng)刷步數(shù)神器-小米運(yùn)動(dòng)刷步數(shù)神器下載 v2......